Intelligence artificielle

La superintelligence imaginée

L'intelligence artificielle est en plein essor. Les entreprises créent de plus en plus de systèmes d'IA polyvalents et capables d'effectuer de nombreuses tâches différentes. Les grands modèles de langage (LLM) peuvent composer de la poésie, créer des recettes de cuisine et des codes de logiciels. Certains de ces modèles présentent déjà des risques majeurs, tels que l'érosion des processus démocratiques, la généralisation des préjugés et de la désinformation, ainsi qu'une course aux armes autonomes. Mais le pire est à venir.

Les capacités des systèmes d'IA ne cesseront de croître. Les entreprises s'intéressent activement à l'"intelligence artificielle générale" (AGI), qui peut être aussi performante, voire meilleure, que l'être humain pour de très nombreuses tâches. Ces entreprises promettent des avantages sans précédent, allant de la guérison du cancer à l'éradication de la pauvreté dans le monde. En revanche, plus de la moitié des experts en IA estiment qu'il y a une chance sur dix que cette technologie engendre notre extinction.

Cette conviction n'a rien à voir avec les robots maléfiques ou les machines intelligentes que l'on voit dans la science-fiction. À court terme, l'IA avancée pourra permettre à ceux qui cherchent à nuire - les bioterroristes, par exemple - d'exécuter facilement des tâches de traitement complexes sans réfléchir.

À plus long terme, nous ne devrions pas nous focaliser sur une méthode de nuisance spécifique, car les risques proviennent d'une intelligence supérieure. Il suffit de penser à la façon dont l'être humain domine les animaux moins intelligents sans utiliser d'arme particulière, ou à la façon dont un programme d'échecs d'IA bat les joueurs humains sans se baser sur un coup spécifique.

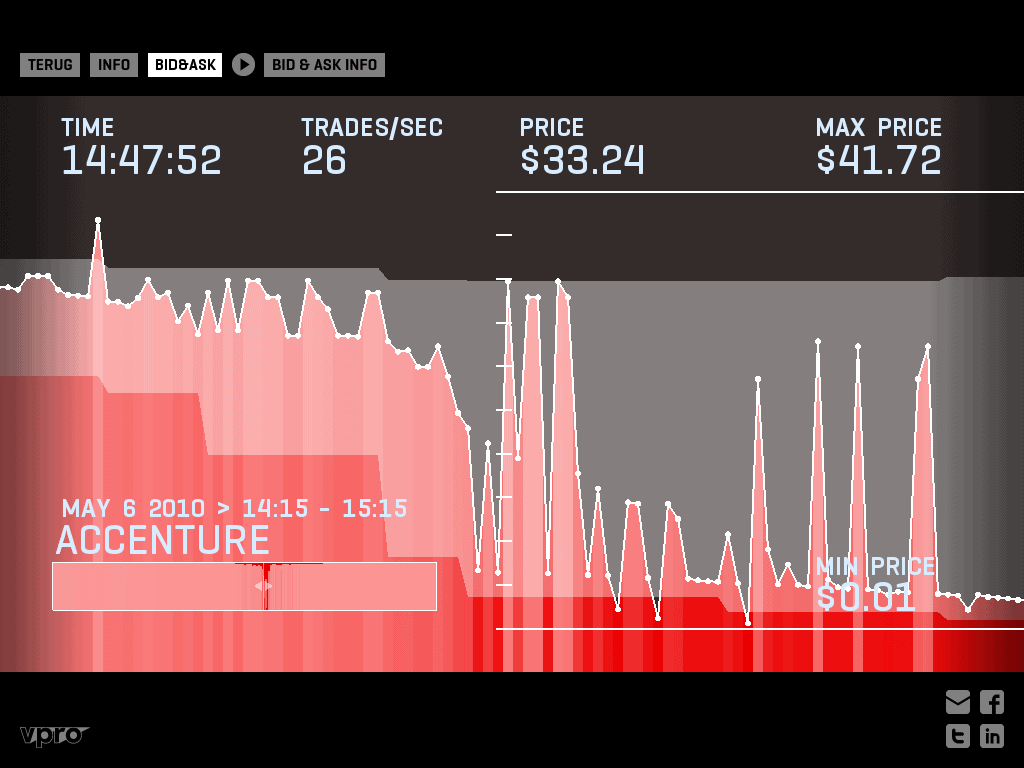

Les militaires pourraient perdre le contrôle d'un système très performant conçu pour nuire, ce qui aurait pour conséquence un impact dévastateur. Un système d'IA avancé, utilisé pour maximiser les profits d'une entreprise, pourrait employer des méthodes drastiques et imprévisibles. Même une IA programmée pour faire quelque chose d'altruiste pourrait poursuivre une méthode destructrice pour atteindre cet objectif. Nous n'avons actuellement aucun moyen de savoir comment les systèmes d'IA agiront, car personne, pas même leurs créateurs, ne comprend leur fonctionnement.

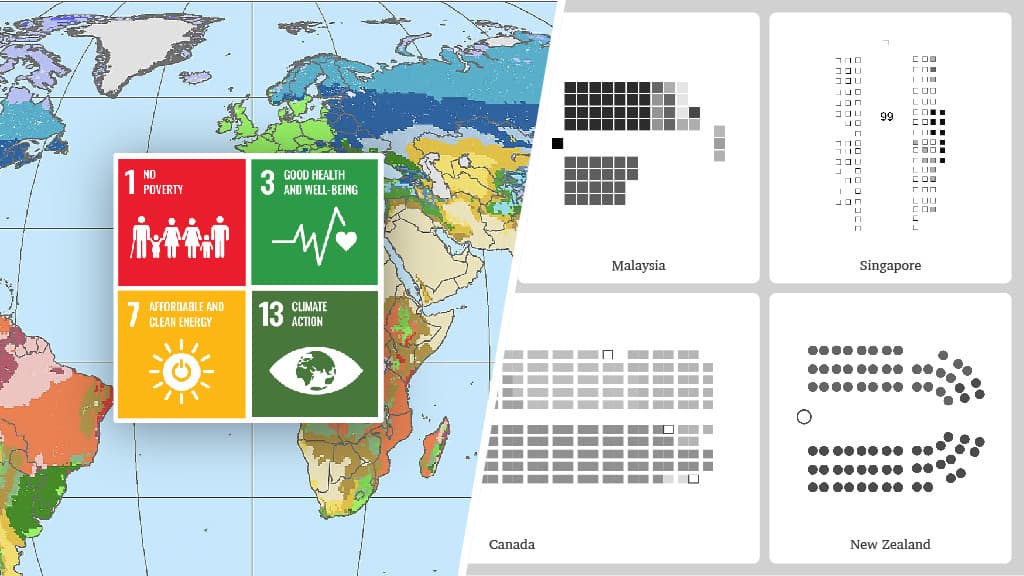

La sécurité de l'IA est devenue une préoccupation majeure. Les experts et le grand public expriment la même inquiétude face aux risques émergents et à la nécessité urgente de les gérer. Mais s'inquiéter ne suffit pas. Nous avons besoin de politiques pour faire en sorte que le développement de l'IA améliore les conditions de vie partout dans le monde, et ne se contente pas d'accroître les profits des entreprises. Nous avons besoin d'une gouvernance appropriée, donc d'une réglementation rigoureuse et d'institutions capables d'orienter cette technologie de transformation en évitant les risques extrêmes et en la mettant au service de l'humanité.

Voir aussi

Notre position sur l'IA

Littérature recommandée

Avantages et risques de l'intelligence artificielle

Autres domaines d'intervention

Armes nucléaires

Biotechnologie

Contenu récent sur l'intelligence artificielle

Articles

Perturber la filière "Deepfake" en Europe

Réaliser des avenirs prometteurs - Nouvelles possibilités de subventions du FLI

La déresponsabilisation progressive par l'IA

Étude de solutions matérielles sécurisées pour un déploiement sécurisé de l'IA

Protéger la loi sur l'IA de l'UE

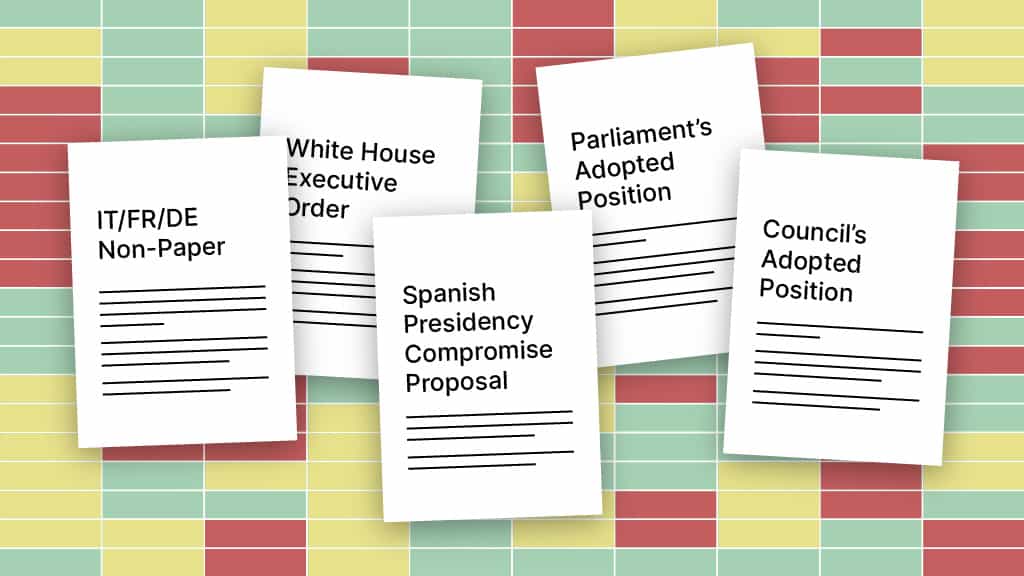

Des kilomètres à la ronde : comparaison des principales propositions de loi sur l'IA

Pouvons-nous nous appuyer sur le partage d'informations ?

Déclaration écrite du Dr. Max Tegmark à l'AI Insight Forum

Ressources

Scénarios catastrophes en matière d'IA

Ressources préliminaires sur les risques liés à l'IA

Politique mondiale en matière d'IA

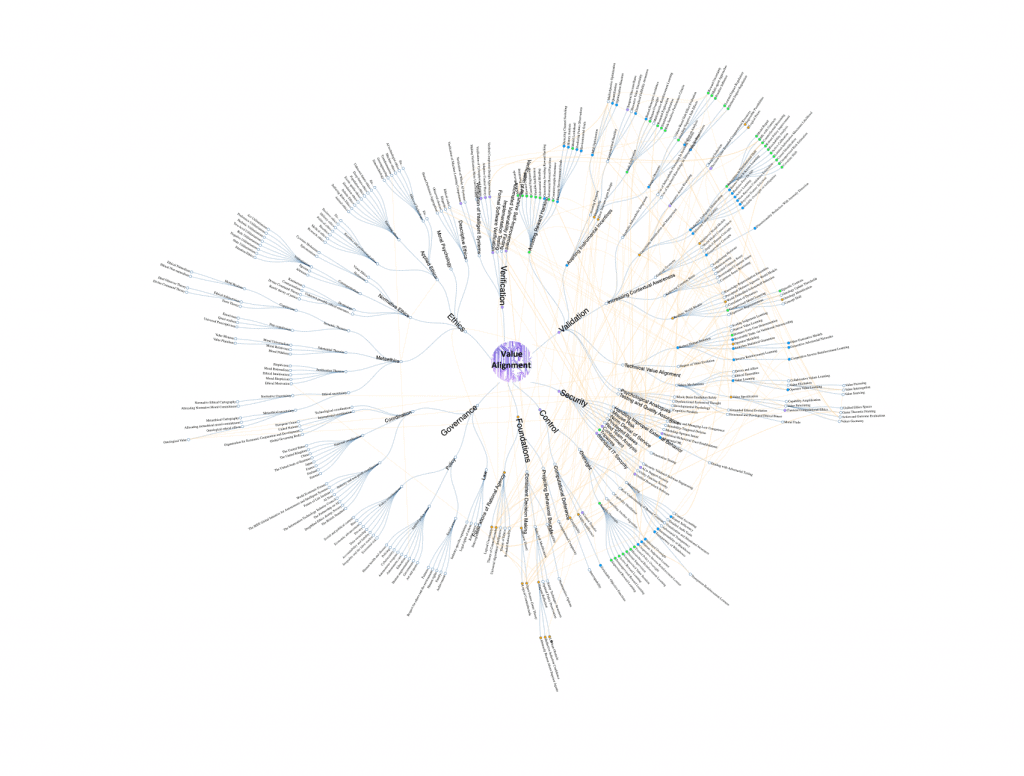

Aperçu de la recherche sur l'alignement de la valeur de l'IA

Documents de politique générale

La concurrence dans l'IA générative : les réactions de l'institut Future of Life à la consultation de la Commission Européenne

Manifeste pour la Commission Européenne 2024-2029

Réponse du FLI à l'OMB : demande de précisions sur la gouvernance, l'innovation et la gestion des risques en matière d'IA

Réponse du FLI au NIST : demande de précisions sur les missions du NIST dans le cadre du décret sur l'IA

Vidéos

Réglementer l'IA maintenant

La pause de l'IA. Quelle est la prochaine étape ?

Podcasts